Ein Projekt von Patrick Kruse & Paul Kretschel

Hochschule Düsseldorf

mit Prof.in Anja Vormann

Zu Beginn des 20. Jahrhunderts gab es im Deutschen Raum etwa 2800 Synagogen und Gebetsräume. In den Nächten der Novemberpogrome 1938 wurden neben vielen jüdischen Geschäften und Einrichtungen auch eine große Anzahl von Gotteshäusern in Brand gesetzt.

In der Nacht zum 9. November 1938 und in den folgenden Tagen wurden rund 1400 dieser Einrichtungen von den Nazis zerstört. Seitdem steht der 9. November für eine Nacht des Schreckens. Er gilt als der Übergang von der gesellschaftlichen Ausgrenzung von Menschen jüdischen Glaubens zur systematischen Verfolgung in der Diktatur der Nationalsozialisten. Im Zuge des Zweiten Weltkriegs kulminierte der Antisemitismus im Holocaust, dem industrialisierten Völkermord an rund 6 Millionen europäischen Juden.

Das Projekt AR Synagoge zielt darauf ab, einen Hybrid aus physischem und digitalem Erinnerungsort zu schaffen. An ehemaligen Standorten von Berliner Synagogen soll sich ein digitales Portal zur Geschichte öffnen und einen Blick in die Synagogen und jüdischen Gotteshäuser vor 1938 ermöglichen. Repräsentiert durch die Eingangstür des jeweiligen Gebäudes können die Nutzer durch die geöffnete Tür einen Blick in die Vergangenheit werfen.

Neben der Tür ist nur der Innenraum zu sehen. Als Zeichen für den großen Verlust ist die Außenfassade nicht sichtbar.

Sie soll symbolisieren, dass die Inhalte und das Gedankengut dieser Kultur zwar großen Schaden erlitten haben, die Nazis aber den Kern der Kultur nicht auslöschen konnten. Was sie geschafft haben, war die Beschädigung der Hülle, aber sie konnten das jüdische Leben und die Kultur trotz der größten Verbrechen nie ganz auslöschen.

Technische Umsetzung

Das AR-Erlebnis wird auf einem mobilen Gerät wie einem Tablet oder Smartphone laufen. Falls das Projekt als Ausstellung präsentiert werden soll, kann es hilfreich sein, ein solches Gerät für die Besucher vor Ort bereitzustellen.

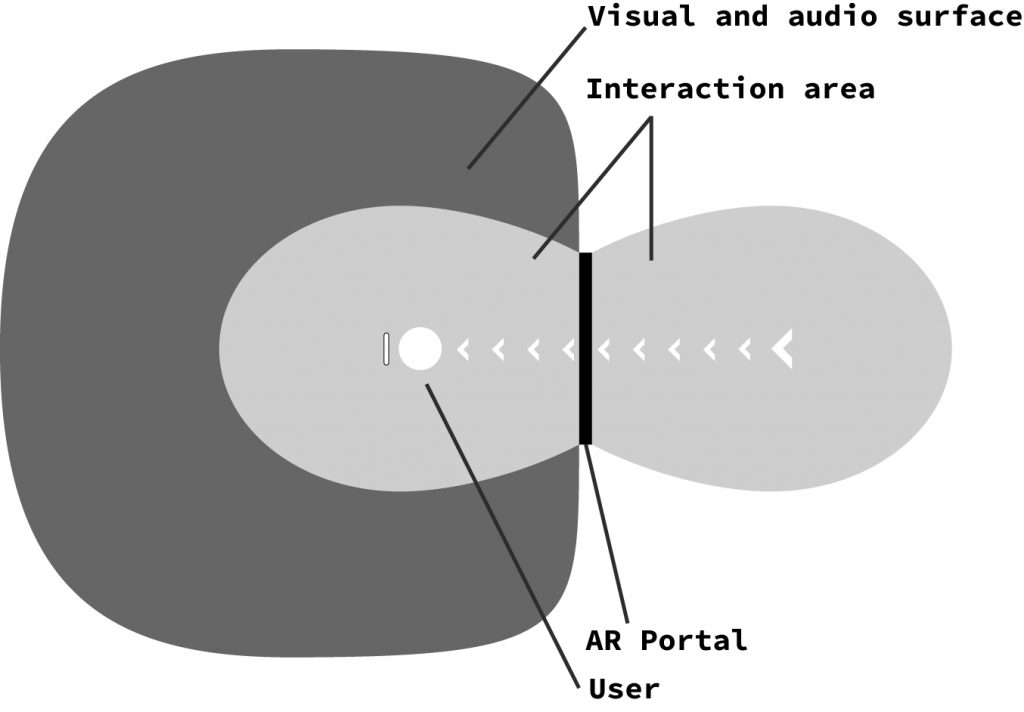

Die App zeigt ein virtuelles Portal an, das auf dem Kameraausgang des Geräts liegt. Die Position des Portals wird durch die Position eines physischen Markers bestimmt, der in der Mitte der Präsentationsfläche auf dem Boden platziert wird. Die Markierung wird ein eindeutig identifizierbares Bild sein, das aus einem robusten Material besteht, so dass es widerstandsfähig ist, wenn jemand darüber läuft.

Dem Betrachter/der Betrachterin wird empfohlen, Kopfhörer zu tragen, da das AR-Erlebnis räumliches Audio unterstützen wird, das hauptsächlich von der Position des Portals ausgeht. Die Klänge werden sich aus authentischen Audioaufnahmen aus echten Synagogen zusammensetzen. Die räumliche Natur dieser Klänge wird die Aufmerksamkeit des Betrachters/der Betrachterin in Richtung des Portals lenken. Je näher der Betrachter dem Portal kommt, desto lauter werden die Klänge, bis der Betrachter schließlich durch das Portal geht, wobei die Klänge den Betrachter/die Betrachterin vollständig umgeben und sein Eintauchen in die Erfahrung verstärken.

Nachdem der Betrachter/die Betrachterin durch das Portal gegangen ist, kann er sich frei in der virtuellen Synagoge bewegen. Beim Blick durch den Bildschirm des Geräts wird die reale Welt nun vollständig hinter den virtuellen Inhalten verborgen, bis der Betrachter/die Betrachterin sich entscheidet, wieder durch das Portal zu gehen. In der virtuellen Welt ist es wichtig, dem Betrachter/der Betrachterin die räumlichen Grenzen der Umgebung zu vermitteln, denn wir wollen nicht, dass der Betrachter/die Betrachterin versehentlich mit dem virtuellen Inhalt kollidiert, da dies die Immersion zerstören würde. Außerdem sollte sich der Betrachter/die Betrachterin nicht zu weit vom Zentrum der Welt entfernen, da es auch physische Grenzen geben könnte (z. B. befahrene Straßen).

Um eine visuelle Begrenzung zu schaffen, die die Immersion nicht zu sehr beeinträchtigt, werden wir die virtuelle Synagoge als Punktwolke darstellen. Diese visuelle Repräsentation einer 3D-Umgebung wird sich automatisch in kleine einzelne Punkte auflösen, sobald der Betrachter zu nahe herankommt (wie im Video oben gezeigt).

Entwicklungs-Journal

01.05.2021

Wir haben einen einfachen Prototyp einer App erstellt, um die Machbarkeit unseres Konzepts zu testen. Wenn die App gestartet wird, sieht der Benutzer das Ausgabevideo der Kamera des Geräts, genau wie bei der Standard-Kamera-App auf jedem Smartphone. Darüber geschichtet zeigt die App ein quadratisches Fenster, das einen virtuellen Raum (derzeit bestehend aus zufällig platzierten Würfeln) zeigt. Beim Blick durch das Fenster zeigt die App den 3D-Inhalt des Raums korrekt in Bezug auf die Position und Ausrichtung des Geräts an. Bewegt sich der Benutzer durch das Fenster, wird er in den virtuellen Raum teleportiert.

Leider flackert im Moment immer dann, wenn die Teleportation stattfindet, die Umgebung hinter dem Fenster für ein paar Frames ins Bild. Das ist sehr schlecht, weil es die Immersion des Benutzers in die virtuelle Welt komplett zerstört, so dass wir in Zukunft definitiv eine Lösung für dieses Problem finden müssen.